Automatización de datos (AutoML), también conocido como machine learning, usando el lenguaje de programación Python y la librería gratuita pycaret. Aplicamos varios modelos de predicción, ajustamos los hiperparámetros, comparamos los modelos según las métricas, guardamos el modelo óptimo final y lo cargamos para su uso en cualquier otro momento.

- Instalación de librería pycaret en Python.

- AutoML con Python y pycaret, predicción de datos, ciencia de datos automática.

- Código Python completo del ejemplo de ciencia de datos automatizada.

Instalación de librería pycaret en Python

En primer lugar, necesitaremos instalar la librería pycaret para Python. Podemos hacerlo abriendo una terminal (consola de comandos) y ejecutando el comando:

|

1 |

pip3 install pycaret |

Se instalará esta librería y la tendremos disponible para su uso en Python.

Si disponemos de docker (podremos instalarlo en Windows como indicamos en este enlace o en Linux en este otro enlace), desplegando de forma rápida un contenedor con Python y pycaret, ejecutando el comando:

|

1 |

docker run -p 8888:8888 pycaret/full |

Para realizar este artículo hemos usado la opción de docker, que nos permite acceder vía web al contenedor desplegado anteriormente, usando el editor Jupyter, que permite ejecutar código Python y mostrar los resultados formateados en html:

AutoML con Python y pycaret, predicción de datos, ciencia de datos automática

Iniciamos importando la librería y cargando un conjunto de datos de pruebas que incluye la propia librería. En concreto, cargaremos y trabajaremos, a modo de ejemplo, con el conjunto de datos credit, que contiene un historial de créditos solicitados a un banco, indicando si han sido pagados o no:

|

1 2 3 |

from pycaret.datasets import get_data dataset = get_data("credit") |

Devolverá las 5 primeras filas del dataset, pudiendo comprobar los campos que contiene:

- IDENTIFICACIÓN: código identificativo del cliente.

- LIMIT_BAL: crédito otorgado en dólares (incluye crédito individual y familiar/suplementario).

- SEX: género (1 = hombre, 2 = mujer).

- EDUCATION: nivel de estudios (1 = posgrado, 2 = universidad, 3 = escuela secundaria, 4 = otros, 5 = desconocido, 6 = desconocido).

- MARRIAGE: estado civil (1 = casado, 2 = soltero, 3 = otros).

- AGE: edad en años.

- PAY_0 a PAY_6: estado de amortización de los últimos seis meses.

- BILL_AMT1 a BILL_AMT6: cantidad económica del estado de cuenta de los últimos seis meses (dólares).

- PAY_AMT1 a PAY_AMT6: cantidad económica del pago anterior de los últimos seis meses (dólares NT).

- default: pago por defecto (1 = sí, 0 = no).

Para ver el número de filas y columnas del dataset, ejecutaremos:

|

1 |

dataset.shape |

Devolverá el número de filas y columnas del conjunto de datos (dataset) escogido para las pruebas:

A continuación, dividiremos los datos en un conjunto de datos nuevo para pruebas (el 95% de los registros) y el 5% restante para entrenar el modelo. Para ello, ejecutaremos el siguiente código Python:

|

1 2 3 4 |

data = dataset.sample(frac=0.95, random_state=786).reset_index(drop=True) data_unseen = dataset.drop(data.index).reset_index(drop=True) print("Datos para el modelo: " + str(data.shape)) print("Datos no visible para predicción: " + str(data_unseen.shape)) |

Devolverá:

Datos para el modelo: (22800, 24)

Datos no visible para predicción: (1200, 24)

Teniendo en cuenta que en la variable data quedarán el 95% de los datos para entrenar el modelo (22.800 registros) y en la variable data_unseen quedarán el 5% para pruebas (1.200 registros). Y teniendo en cuenta también que hemos usado el parámetro «random_state=786» como semilla para obtener los registros.

Realizaremos la clasificación para el dataset data (con el 95% de los registros) en base a la columna default, que contiene 1 si el crédito ha sido pagado y 0 en caso contrario:

|

1 2 3 |

from pycaret.classification import * exp_clf101 = setup(data = data, target = "default", session_id=10001) |

Nos devolverá todos los datos del setup, con las acciones que aplicará al dataset:

Tendríamos que proceso realiza sobre los datos cada una de las acciones anteriores, para decidir si las generadas automáticamente son suficientes o no. Esta cuestión la dejamos para los expertos en automatización de datos. Para este artículo, dejaremos las acciones generadas como válidas.

Usando la capacidad de pycaret para ciencia de datos automática (AutoML), realizaremos la comparación de modelos, mostrando las métricas de: accuracy, AUC, Recall, Prec., F1, Kapp, MCC para varios modelos de ciencia de datos (gbc, lightgbm, ada, catboost, rf, lda, xgboost, et, ridge, dummy, lr, svm, knn, dt, qda, nb, etc.). Para ello, ejecutaremos la siguiente línea de código Python:

|

1 |

best_model = compare_models() |

Hay que tener en cuenta que nosotros somos los que debemos elegir la métrica idónea según la intención del modelo de datos. Por ejemplo, si el modelo de datos queremos realizarlo para alguna predicción que requiera de no dejarnos ningún posible valor potencial, elegiríamos el que mayor métrica de recall haya dado, en el ejemplo elegiríamos el modelo nb (Naive Bayes).

Mostramos el mejor algoritmo y sus hiperparámetros, en este caso se usa (si no se indica otra cosa) el mejor algoritmo según la métrica accuracy, que para el ejemplo ha sido gbc (Gradient Boosting Classifier) con:

|

1 |

print(best_model) |

Devolverá:

|

1 2 3 4 5 6 7 8 9 |

GradientBoostingClassifier(ccp_alpha=0.0, criterion='friedman_mse', init=None, learning_rate=0.1, loss='log_loss', max_depth=3, max_features=None, max_leaf_nodes=None, min_impurity_decrease=0.0, min_samples_leaf=1, min_samples_split=2, min_weight_fraction_leaf=0.0, n_estimators=100, n_iter_no_change=None, random_state=10001, subsample=1.0, tol=0.0001, validation_fraction=0.1, verbose=0, warm_start=False) |

Si queremos mostrar los modelos con los que probará al realizar una clasificación, ejecutaremos:

|

1 |

models() |

Comparamos los modelos y obtenemos el mejor:

|

1 |

best_model = compare_models() |

En este caso, escogeremos el modelo Decision Tree Classifier (dt). Como hemos dicho anteriormente, elegiremos el modelo en función de la naturaleza y uso de los datos y, por ello, en base a la métrica que más se ajuste a estas características. Como ejemplo, elegiremos dt. Para escoger el modelo, introduciremos la siguiente línea de código:

|

1 |

dt = create_model("dt") |

Esto nos mostrará el cross validation (validación cruzada) que hizo para los 10 folds para un algoritmo en particular (para el dt en este caso):

Mostramos el modelo dt y los hiperparámetros:

|

1 |

print(dt) |

|

1 2 3 4 5 |

DecisionTreeClassifier(ccp_alpha=0.0, class_weight=None, criterion='gini', max_depth=None, max_features=None, max_leaf_nodes=None, min_impurity_decrease=0.0, min_samples_leaf=1, min_samples_split=2, min_weight_fraction_leaf=0.0, random_state=10001, splitter='best') |

Al igual que hemos hecho para el modelo dt, también podríamos generar cualquier otro modelo, como el knn y comparar los resultados (si lo estimamos oportuno):

|

1 |

knn = create_model("knn") |

Y mostrar el modelo knn y sus hiperparámetros:

|

1 |

print(knn) |

|

1 2 3 |

KNeighborsClassifier(algorithm='auto', leaf_size=30, metric='minkowski', metric_params=None, n_jobs=-1, n_neighbors=5, p=2, weights='uniform') |

Otro ejemplo, generando el modelo rf:

|

1 |

rf = create_model("rf") |

Y mostrando el modelo rf y sus hiperparámetros:

|

1 |

print(rf) |

|

1 2 3 4 5 6 7 |

RandomForestClassifier(bootstrap=True, ccp_alpha=0.0, class_weight=None, criterion='gini', max_depth=None, max_features='sqrt', max_leaf_nodes=None, max_samples=None, min_impurity_decrease=0.0, min_samples_leaf=1, min_samples_split=2, min_weight_fraction_leaf=0.0, n_estimators=100, n_jobs=-1, oob_score=False, random_state=10001, verbose=0, warm_start=False) |

Tuneamos el modelo dt generado anteriormente, aplicando la hiperparametrización. El tuneado realiza las combinaciones potenciales y entrenamientos, modificando los parámetros, para obtener los que mejores resultados den.

|

1 |

tuned_dt = tune_model(dt) |

Mostramos el modelo sin tunear y sus hiperparámetros:

|

1 |

print(dt) |

|

1 2 3 4 5 |

DecisionTreeClassifier(ccp_alpha=0.0, class_weight=None, criterion='gini', max_depth=None, max_features=None, max_leaf_nodes=None, min_impurity_decrease=0.0, min_samples_leaf=1, min_samples_split=2, min_weight_fraction_leaf=0.0, random_state=10001, splitter='best') |

Y mostramos el modelo tuneado con los hiperparámetros que haya considerado modificar (por ejemplo el parámetro min_impurity_decrease, pasando de 0 a 0.02):

|

1 |

print(tuned_dt) |

|

1 2 3 4 5 |

DecisionTreeClassifier(ccp_alpha=0.0, class_weight=None, criterion='gini', max_depth=16, max_features=1.0, max_leaf_nodes=None, min_impurity_decrease=0.02, min_samples_leaf=4, min_samples_split=7, min_weight_fraction_leaf=0.0, random_state=10001, splitter='best') |

La librería nos permite modificar el valor de cualquiera de los parámetros generados automáticamente. Por ejemplo, para modificar el valor del parámetro n_neighbors, para el modelo knn, usaremos:

|

1 2 3 |

import numpy as np tuned_knn = tune_model(knn, custom_grid = {"n_neighbors":np.arange(0, 50, 1)}) |

Mostrándonos sus métricas, para decidir si nos conviene dejarlo en este valor o modificarlo:

Mostramos el modelo sin tunear y tuneado con sus hiperparámetros correspondientes (igual que hicimos para el modelo dt):

|

1 |

print(knn) |

|

1 2 3 |

KNeighborsClassifier(algorithm='auto', leaf_size=30, metric='minkowski', metric_params=None, n_jobs=-1, n_neighbors=5, p=2, weights='uniform') |

|

1 |

print(tuned_knn) |

|

1 2 3 |

KNeighborsClassifier(algorithm='auto', leaf_size=30, metric='minkowski', metric_params=None, n_jobs=-1, n_neighbors=46, p=2, weights='uniform') |

De igual forma para el modelo rf, aplicamos el tuneado:

|

1 |

tuned_rf = tune_model(rf) |

Mostramos el modelo rf y sus hiperparámetros sin tunear:

|

1 |

print(rf) |

|

1 2 3 4 5 6 7 |

RandomForestClassifier(bootstrap=True, ccp_alpha=0.0, class_weight=None, criterion='gini', max_depth=None, max_features='sqrt', max_leaf_nodes=None, max_samples=None, min_impurity_decrease=0.0, min_samples_leaf=1, min_samples_split=2, min_weight_fraction_leaf=0.0, n_estimators=100, n_jobs=-1, oob_score=False, random_state=10001, verbose=0, warm_start=False) |

Mostramos el modelo rf y sus hiperparáemtros tuneado:

|

1 |

print(tuned_rf) |

|

1 2 3 4 5 6 7 |

RandomForestClassifier(bootstrap=True, ccp_alpha=0.0, class_weight={}, criterion='entropy', max_depth=6, max_features=1.0, max_leaf_nodes=None, max_samples=None, min_impurity_decrease=0, min_samples_leaf=3, min_samples_split=9, min_weight_fraction_leaf=0.0, n_estimators=240, n_jobs=-1, oob_score=False, random_state=10001, verbose=0, warm_start=False) |

Dibujamos las gráficas para ver, de forma visual, cómo se han comportado los modelos. Por ejemplo, para mostrar la curva de ROC para el modelo rf, usaremos la siguiente línea de código Python:

|

1 |

plot_model(tuned_rf, plot = "auc") |

Para mostrar la gráfica de Precision-Recall también para el modelo rf:

|

1 |

plot_model(tuned_rf, plot = "pr") |

O también la gráfica de Feature Importance para el modelo rf:

|

1 |

plot_model(tuned_rf, plot = "feature") |

Y la matriz de confusión para el modelo rf:

|

1 |

plot_model(tuned_rf, plot = "confusion_matrix") |

Evaluamos el modelo con:

|

1 |

evaluate_model(tuned_rf) |

Y hacemos la predicción del modelo rf tuneado para ver cómo se comporta:

|

1 |

predict_model(tuned_rf) |

Generamos el modelo final:

|

1 |

final_rf = finalize_model(tuned_rf) |

Mostramos el modelo final rf con sus hiperparámetros:

|

1 |

print(final_rf) |

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 |

Pipeline(memory=FastMemory(location=/tmp/joblib), steps=[('numerical_imputer', TransformerWrapper(exclude=None, include=['LIMIT_BAL', 'SEX', 'EDUCATION', 'MARRIAGE', 'AGE', 'PAY_1', 'PAY_2', 'PAY_3', 'PAY_4', 'PAY_5', 'PAY_6', 'BILL_AMT1', 'BILL_AMT2', 'BILL_AMT3', 'BILL_AMT4', 'BILL_AMT5', 'BILL_AMT6', 'PAY_AMT1', 'PAY_AMT2', 'PAY_AMT3', 'PAY_AMT4', 'PAY_AMT5', 'PAY_AMT6'... RandomForestClassifier(bootstrap=True, ccp_alpha=0.0, class_weight={}, criterion='entropy', max_depth=6, max_features=1.0, max_leaf_nodes=None, max_samples=None, min_impurity_decrease=0, min_samples_leaf=3, min_samples_split=9, min_weight_fraction_leaf=0.0, n_estimators=240, n_jobs=-1, oob_score=False, random_state=10001, verbose=0, warm_start=False))], verbose=False) |

Hacemos la predicción con el modelo final:

|

1 |

predict_model(final_rf) |

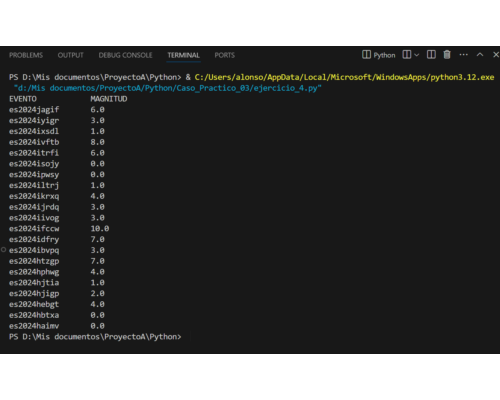

Hacemos la predicción con los datos iniciales almacenados en data_unseen (el dataset de 1.200 registros para pruebas):

|

1 2 |

unseen_predictions = predict_model(final_rf, data = data_unseen) unseen_predictions.head() |

Generamos y guardamos en fichero el modelo final, listo para usarse en cualquier momento:

|

1 2 3 4 |

from pycaret.utils.generic import check_metric check_metric(unseen_predictions.default, unseen_predictions.prediction_label, "Accuracy") save_model(final_rf, "Modelo final") |

Devolviendo:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 |

Transformation Pipeline and Model Successfully Saved (Pipeline(memory=FastMemory(location=/tmp/joblib), steps=[('numerical_imputer', TransformerWrapper(exclude=None, include=['LIMIT_BAL', 'SEX', 'EDUCATION', 'MARRIAGE', 'AGE', 'PAY_1', 'PAY_2', 'PAY_3', 'PAY_4', 'PAY_5', 'PAY_6', 'BILL_AMT1', 'BILL_AMT2', 'BILL_AMT3', 'BILL_AMT4', 'BILL_AMT5', 'BILL_AMT6', 'PAY_AMT1', 'PAY_AMT2', 'PAY_AMT3', 'PAY_AMT4', 'PAY_AMT5', 'PAY_AMT6'... RandomForestClassifier(bootstrap=True, ccp_alpha=0.0, class_weight={}, criterion='entropy', max_depth=6, max_features=1.0, max_leaf_nodes=None, max_samples=None, min_impurity_decrease=0, min_samples_leaf=3, min_samples_split=9, min_weight_fraction_leaf=0.0, n_estimators=240, n_jobs=-1, oob_score=False, random_state=10001, verbose=0, warm_start=False))], verbose=False), 'Modelo final.pkl') |

En caso de querer cargar este modelo en otro equipo o en otra ocasión, ejecutaríamos la siguiente línea (disponiendo del fichero del modelo generado anteriormente):

|

1 2 3 |

saved_final_ref = load_model("Modelo final") new_prediction = predict_model(saved_final_ref, data = data_unseen) new_prediction.head() |

Código Python completo del ejemplo de ciencia de datos automatizada

El código Python completo usado anteriormente:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 |

from pycaret.datasets import get_data dataset = get_data("credit") dataset.shape data = dataset.sample(frac=0.95, random_state=786).reset_index(drop=True) data_unseen = dataset.drop(data.index).reset_index(drop=True) print("Datos para el modelo: " + str(data.shape)) print("Datos no visible para predicción: " + str(data_unseen.shape)) from pycaret.classification import * exp_clf101 = setup(data = data, target = "default", session_id=10001) best_model = compare_models() print(best_model) models() best_model = compare_models() dt = create_model("dt") print(dt) knn = create_model("knn") print(knn) rf = create_model("rf") print(rf) tuned_dt = tune_model(dt) print(dt) print(tuned_dt) import numpy as np tuned_knn = tune_model(knn, custom_grid = {"n_neighbors":np.arange(0, 50, 1)}) print(knn) print(tuned_knn) tuned_rf = tune_model(rf) print(rf) print(tuned_rf) plot_model(tuned_rf, plot = "auc") plot_model(tuned_rf, plot = "pr") plot_model(tuned_rf, plot = "feature") plot_model(tuned_rf, plot = "confusion_matrix") evaluate_model(tuned_rf) predict_model(tuned_rf) final_rf = finalize_model(tuned_rf) print(final_rf) predict_model(final_rf) unseen_predictions = predict_model(final_rf, data = data_unseen) unseen_predictions.head() from pycaret.utils.generic import check_metric check_metric(unseen_predictions.default, unseen_predictions.prediction_label, "Accuracy") save_model(final_rf, "Modelo final") saved_final_ref = load_model("Modelo final") new_prediction = predict_model(saved_final_ref, data = data_unseen) new_prediction.head() |